爬虫软件的概述

在当今信息爆炸的时代,爬虫软件扮演着极其重要的角色。爬虫软件,顾名思义,是一种自动获取网页信息的程序,其工作原理类似于蜘蛛在网上爬行,因此得名为“爬虫软件”。

爬虫软件的作用非常广泛,可用于搜索引擎的信息检索、网页内容更新监测、数据挖掘以及网络内容分析等多个领域。通过爬虫软件,我们可以极大地提高数据的获取效率,节省大量人力物力。

爬虫软件的发展历程可以追溯到上世纪90年代,随着互联网的普及和发展,爬虫技术逐渐成熟。从最初的简单文本抽取到如今的复杂数据分析,爬虫软件在不断演进和完善,为信息时代的发展提供了强大的支撑。

爬虫软件的应用

爬虫软件在当今社会的应用非常广泛,从数据分析到市场研究,几乎贯穿了各行各业。下面将分别从爬取数据的方法、爬虫技术原理以及选择考虑因素三个方面来探讨爬虫软件的应用。

2.1 爬取数据的方法

爬虫软件通过模拟人的浏览行为,在网站上自动化地爬取数据,克服了人工获取大量数据的单一性和低效性。爬取数据的方法主要有两种:第一种是通用爬虫,通过对网页进行深度优先搜索,逐级抓取信息;第二种是聚焦爬虫,根据预先设定的规则,有选择地爬取特定网页或特定内容。通过这些方法,爬虫软件可以高效地获取大量的信息,为后续数据分析和应用提供支持。

2.2 爬虫技术原理

爬虫软件的技术原理主要包括链接管理、页面下载、页面解析和数据存储等几个过程。首先,通过链接管理,爬虫软件确定要爬取的网页链接;然后,进行页面下载,将网页内容下载到本地;接着,进行页面解析,提取出页面中的文本、图片等有用信息;最后,将提取的数据进行存储,便于后续的分析和应用。这些技术原理的结合,使得爬虫软件可以高效地实现数据的获取和处理。

2.3 爬虫软件的选择考虑因素

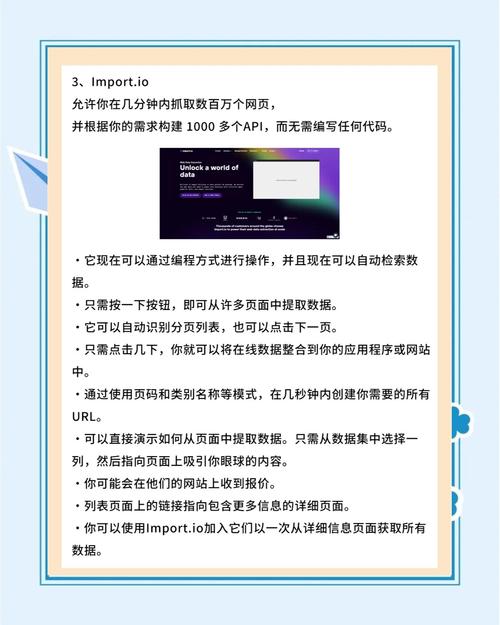

在选择适合的爬虫软件时,需要考虑多个因素,如数据爬取的速度、爬虫的稳定性、是否支持JavaScript渲染、是否有IP代理池等。同时,还需要考虑爬虫软件的价格、用户友好程度以及技术支持等因素。综合考虑这些因素,可以选择一款适合自身需求的爬虫软件,提高数据爬取的效率和质量。

通过对爬虫软件的应用方法、技术原理以及选择考虑因素的探讨,我们可以更全面地了解爬虫软件的工作机制和使用场景,为我们更好地利用爬虫软件提供了指导和支持。